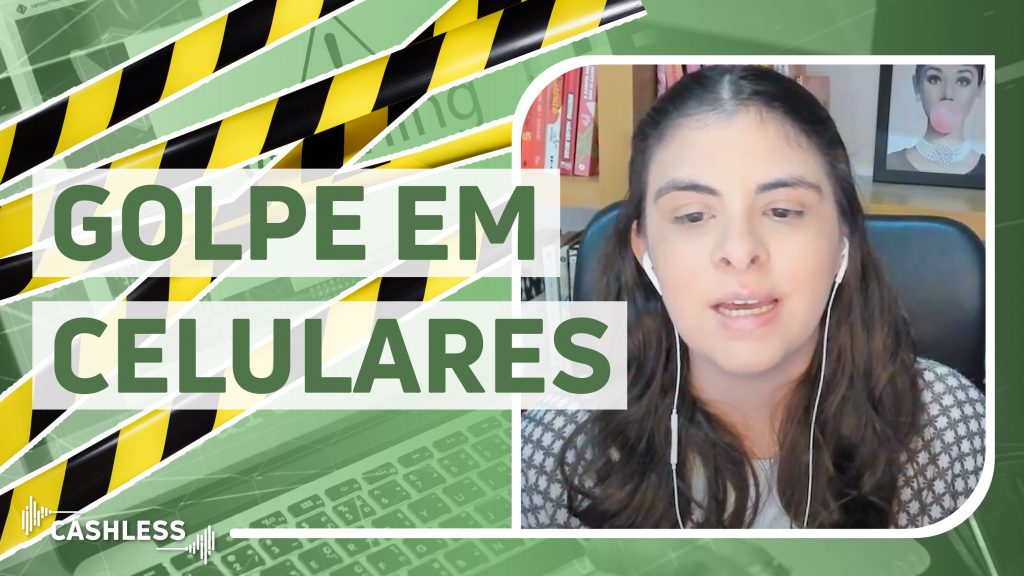

O uso da inteligência artificial em crimes financeiros tem feito com que as organizações intensifiquem o debate e aumentem a sua atenção em relação a seus programas de risco e conformidade, pavimentando mais rapidamente o caminho para a regulação dessa tecnologia.

Especialmente quando se considera aplicativos como o ChatGPT, capazes de impulsionar a inovação, incrementar a produtividade e contribuir para o crescimento da economia, mas que, ao mesmo tempo, trazem preocupações crescentes acerca das ameaças que podem representar para a privacidade e a segurança dos indivíduos. Ainda mais em casos onde essa mesma tecnologia é utilizada para se praticar, por exemplo, esquemas financeiros fraudulentos cada vez mais sofisticados.

Afinal, os avanços tecnológicos e o uso da inteligência artificial na comunicação vêm criando interações cada vez mais naturais e realistas entre as pessoas e as máquinas, abrindo consideravelmente as portas para ação dos cibercriminosos.

Em um insight publicado pela Refintiv, a empresa chama a atenção para a questão abordando os alertas recentes da Europol, força policial da União Europeia (UE), sobre a probabilidade de que o ChatGPT passe a ser utilizado indevidamente em crimes compreendendo phishing, fraudes, desinformação e propaganda, bem como produção de malwares.

De acordo com a Europol, desde o lançamento da ferramenta, outras empresas estão lançando produtos similaresatraindo, ao mesmo tempo a atenção de pessoas mal-intencionadas.

Saiba mais sobre inteligência artificial clicando aqui.

Atenção às políticas de risco e conformidade das organizações

Diante desse cenário, a recomendação é que as organizações do setor financeiro, como bancos e fintechs, redobrem os cuidados com suas políticas de risco, assegurando um controle mais rígido sobre os processos necessários a fim de se resguardar contra atividades ilícitas e garantir conformidade com as leis.

Segundo um white paper também publicado pela Refinitiv, conjuntamente com a consultoria global Fintrail, as dificuldades enfrentadas pelas empresas financeiras estão principalmente atreladas a ativos digitais, especialmente criptomoedas, sanções e fraudes online.

Aliás, as fraudes virtuais são uma ameaça constante, tendo em vista que os cibercriminosos passaram a recorrer a identidades artificiais, juntamente com outras tecnologias de ponta, para emitir documentos falsificados, expõe o relatório.

Ao mesmo tempo, esse panorama também propicia ações mais rápidas por parte das autoridades em todos os países sobre o uso da inteligência artificial, capaz de resultar no desenvolvimento e implementação de uma estrutura regulatória o quanto antes.

Nesse sentido, os ministros da área de tecnologia do G7, grupo dos sete países mais desenvolvidos economicamente do mundo, emitiram, recentemente, um comunicado após uma reunião de dois dias, realizada em maio, no Japão, observando o potencial de impactos negativos na sociedade ante o rápido avanço da inteligência artificial, incluindo, notadamente, o ChatGPT.

Conforme o documento, a regulamentação do uso da inteligência artificial deve ser baseada no risco e voltada para o futuro, enquanto procura proteger os direitos humanos, os valores democráticos e a privacidade pessoal.

Nessa direção, eles endossaram um plano de ação sobre inteligência artificial para promover a interoperabilidade global entre ferramentas envolvendo essa tecnologia que sejam confiáveis e se comprometeram com reuniões futuras sobre inteligência artificial regenerativa, abrangendo governança, direitos de propriedade intelectual, transparência e desinformação.

A discussão sobre a regulação do uso da inteligência artificial nos EUA e na Europa

No final de abril, quatro agências federais dos Estados Unidos (EUA) emitiram uma declaração conjunta reafirmando seu compromisso de promover a inovação responsável em sistemas automatizados, protegendo o público de preconceitos por meio do uso da inteligência artificial.

Concomitantemente, o senador Michael Bennet apresentou um projeto de lei a fim de criar uma força-tarefa para analisar as políticas dos EUA sobre o uso da inteligência artificial, bem como identificar maneiras de como diminuir os riscos à privacidade, às liberdades civis e ao devido processo legal.

Enquanto isso, no dia 11 de maio de 2023, os deputados europeus chegaram a um acordo preliminar sobre o projeto de lei para regulamentar o uso da inteligência artificial na UE. Eles aprovaram por ampla maioria a utilização da tecnologia no bloco, mediante novas proibições, mas mantendo incentivos concedidos até então. Ao passo que solicitaram uma avaliação mais detalhada do ChatGPT.

A saber, o texto validado contém alguns dos eixos principais da proposta apresentada há dois anos pela Comissão Europeia, mas também recomenda a proibição de práticas como o reconhecimento de emoções dos indivíduos, vigilância biométrica, e uso da inteligência artificial para patrulhamento policial de forma preditiva.

Agora, a expectativa é de que o texto seja levado a plenário em junho. Caso seja aprovado, a etapa seguinte será de negociação com os países integrantes da UE para finalizar a redação da lei em definitivo.

O panorama no Brasil

As iniciativas para regulação do uso da inteligência artificial também avançaram no Brasil. No início de maio, o presidente do Senado apresentou projeto de lei que define regras gerais para o desenvolvimento, implantação e uso da tecnologia no país.

O documento é fruto do trabalho de um grupo de juristas, constituído em 2022, para criar uma proposta de um texto regulatório sobre a inteligência artificial, que contemplasse outros projetos de lei já apresentados no Parlamento.

O referido texto pretende proteger os direitos fundamentais dos indivíduos e assegurar a implementação de sistemas de inteligência artificial que sejam seguros e confiáveis, atentando ainda para a garantia do regime democrático.

Além disso, pretende dispor de mecanismos de governabilidade e criação de arranjo institucional para fiscalizar e supervisionar o desenvolvimento dos sistemas com essa tecnologia. Entre os principais pontos estão:

- Garantir que as pessoas tenham conhecimento acerca da exposição a sistemas de reconhecimento de emoções ou de caracterização por biometria;

- Assegurar privacidade e proteção de dados pessoais;

- Garantir que sistemas de inteligência artificial voltados para menores, idosos e pessoas com deficiência sejam criados visando à compreensão de seu funcionamento por esses públicos;

- Fazer com que toda solução passe por análise prévia pelo fornecedor a fim de identificar os níveis de risco antes de ser colocada no mercado;

- Garantir a proibição do uso da inteligência artificial de forma a induzir as pessoas a se comportarem de forma prejudicial ou nociva à saúde e à segurança;

- Assegurar que na segurança pública o uso da tecnologia sirva apenas para identificação biométrica à distância;

- Certificar de que qualquer solução seja classificada por uma autoridade competente quanto aos seus riscos; e

- Responsabilizar os agentes de inteligência artificial pela notificação de ocorrências de incidentes graves de segurança, violação aos direitos fundamentais e danos ao meio ambiente e à propriedade.

Veja mais:

Inteligência Artificial no Sistema Financeiro: onde se aplica?

Inteligência artificial está mudando o mercado financeiro: os benefícios são maiores que os riscos?

Inteligência artificial: a tendência de impactos positivos é constante, mas a ausência de regulação acende um alertaO papel da inteligência artificial no combate de fraudes: ameaça ou solução para os pagamentos?

ChatGPT: Quais as aplicações práticas dessa e de outras IAs no mercado financeiro?